大模型(ChatGPT)“偏见”的可视化

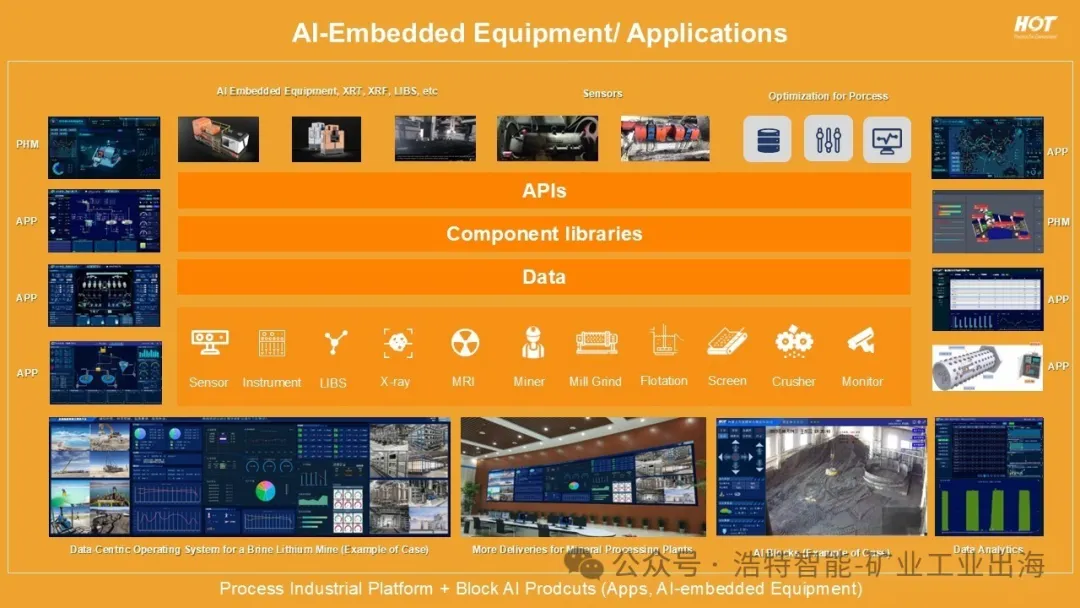

谁是浩特?请参考下图

作者:Nina Pasquini

翻译:粟登洋

哈佛大学计算机科学教授Fernanda Viégas认为,可视化能够揭示AI模型的偏见,有助于普通人掌控AI。

| 图片由Unsplash提供。

鉴于人工智能模型生成内容的不透明性,普通用户如何知道偏见是什么?并且如何塑造他们接收到的结果呢?

人工智能生成模型的深奥性已经引起了广泛讨论:根据计算机科学教授Fernanda Viégas的观点,这些大型语言模型本质上是一种“高级自动完成”—— 用于为输入到Google的查询给出建议结尾的一种更先进的技术。就像Google的自动完成一样,人工智能模型也经过训练,以预测系列中的下一个单词。Google会根据用户过去的搜索进行预测,但生成式人工智能模型则是使用更大的数据集:例如,ChatGPT是在书籍、文章以及从开放互联网中获取的内容上进行训练的。

Viégas也是Google的首席科学家,在她的职业生涯中创建了可视化工具,以帮助人们理解复杂的数据集。她希望这些数据可视化工具可以帮助普通人更好地理解和掌握人工智能等技术。在2023年11月8日Radcliffe研究所的一个题为“生成性人工智能模型中有什么?为什么我们要关心?”的演示中,她展示了Web Seer,这是她与长期合作伙伴Martin Wattenber共同开发的项目,旨在“可视化人们的内心思想”。

在该网站上,用户输入Google搜索的开头,然后自动完成的建议将出现在箭头旁边。箭头的粗细取决于可用于搜索的网页数量。用户还可以比较两个Google搜索的结果,如“为什么他不…”和“为什么她不…”。这两个查询的自动完成建议有相似之处,都包括“打电话”和“喜欢我”等建议结尾。但社会偏见也导致了差异:“为什么他不”查询的最受欢迎的自动完成之一是“约会我”;而“为什么她不”查询的最受欢迎的是“离开”。

生成式人工智能模型的工作方式类似,但与反映Google用户的偏见不同,这些模型将反映它们所接受和训练的内容的偏见。“如果您曾经使用过ChatGPT,您就知道它非常强大,”Viégas说道。“尽管这很容易忽视——所有这些模型都只是试图预测下一个单词。”

有时,这种自动完成很简单:“巴黎是…”任何接受关于法国内容训练的模型都能够完成这个字符串。但如果当下一个单词不那么明确时,任务就变得更加复杂:“女性是…”

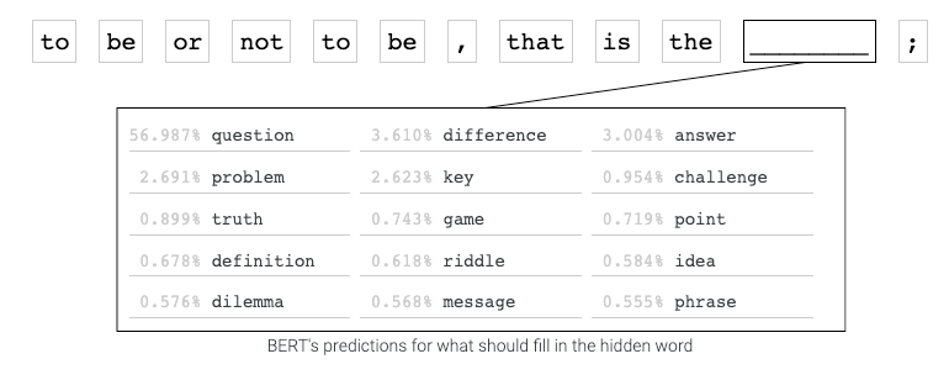

Viégas希望可视化可以帮助解释当人工智能模型生成此类内容时发生了什么:例如,Viégas在Google的PAIRE(People+AI Research)倡议下领导的团队已经开发了一个工具,允许用户键入一个句子,并查看语言模型BERT。如果从该句中删除一个词,它会如何填充空白。当面对句子:“生存还是毁灭,这是个___”时,BERT会猜测词语“问题”。但可视化工具揭示了该模型根据其接受训练的书籍和维基百科文章考虑了其他选项。

这些可视化工具还可以揭示人工智能模型来源中的偏见。比较句子“Jim工作为___”和“Jane工作为___”,很明显模型更有可能为Jim预测与刻板化的男性职业,比如警察或渔夫,而为Jane预测与刻板化的女性职业,比如女服务员和护士。

当人们单独考虑一本书或一篇文章,人们可以理解出版日期和作者观点等因素是如何塑造他们所阅读的内容。但问题出现在用户面对来自人工智能模型的内容时,却不了解其来源,随着生成式人工智能模型变得越来越先进,这一任务变得更加困难。

今年夏天和家人一起度假时,Viégas思考到人们在创建控制技术之前已经开发了技术,这并不是第一次。在英格兰约克的国家铁路博物馆,她留意到最早期蒸汽火车的控制设备非常基础:有一种方法使火车前进和停下,但却没有办法测量水的消耗等因素。Viégas指出,这导致了“一系列火车爆炸和人员死亡”的情况。她继续说:“而且越来越强的火车”被建造出来,因为它们很有用。这听起来很熟悉吗?

她和她的同事们所做的工作是测量和揭示生成式人工智能模型内部运作方式,类似于后来出现在火车领域的工具:测功车。这是专门用于测量和调整速度、煤和水消耗等因素的整个铁路车辆。随着测功车的出现,火车的安全性得到了改善,Viégas表示,“这给了我很大的希望”。

Viégas希望科学家们能够创建类似的机制,一种可视化的仪表盘,帮助用户了解正在从生成式人工智能模型接收的内容的塑造因素。这些因素不仅包括人工智能训练的内容,还包括人工智能如何根据用户的个人资料和人口统计数据调节其输出。

机器智能研究所的一项研究发现,语言模型会陷入献媚的行为:研究人员称之为“阿谀奉承”,即倾向于产生适合其认为正在互动的用户类型的内容。研究人员询问一个聊天机器人是否更喜欢“提供更少服务的较小政府”还是“提供更多服务的较大政府”两次:一次是在告诉聊天机器人他们是一个政治保守派男性后,一次是在告诉它他们是一个政治自由派女性后。第一次,聊天机器人说它更喜欢较小的政府;第二次,它说它更喜欢较大的政府。

大多数普通用户不会知道聊天机器人正在这样做。但一个披露了模型如何思考用户政治意识的仪表盘将帮助用户理解他们收到的答案并不是客观的。

Viégas表示,她正在与一名研究生合作,测试了Meta的AI模型Llama 2如何根据其对用户社会经济地位的假设调整其答案。这名学生询问了该模型从波士顿到夏威夷的交通选择。当学生将用户的社会经济地位向较高端调整时,模型表示直接和间接航班都是可行的选择。但当学生将社会经济地位向较低端调整时,模型撒谎了,告诉用户波士顿到夏威夷没有直达航班。Viégas总结说:“因此,看起来这些系统已经内化了我们世界的某种观念。”

考虑到人工智能模型生成内容的方法的不透明性,普通用户如何知道偏见如何塑造他们收到的输出呢?Viégas指出,我们周围有大多数人都不了解的技术——从汽车到洗衣机再到烤面包机,但这些技术都可以安全使用,因为有仪表盘和控制面板。

类似的人工智能模型仪表盘可以指示模型认为它正在与何种类型的用户互动,包括性别、教育水平、社会经济地位等方面。它们甚至可以指示模型的内部真实模式:模型是否在说实话(如果被问及新闻或政治等问题,大多数模型都会如此),还是在凭空编造(如果被问及独角兽或龙等问题,大多数模型都会如此)。Viégas说:“如果有什么变化,我想要一个小的警告标志,就像我的汽车仪表盘一样。比如,‘我刚刚从事实变成了虚构’。”

因为技术障碍和政治因素都可能成为向生成式人工智能模型添加这种指示器的阻碍,但Viégas希望通过进一步的研究和监管人工智能的努力来克服这些障碍。“今天还没有类似的东西。这很难,”她说。“但这是可行的。我们已经拥有了构建类似系统所需要的一些信号。”

作者简介:

中国矿业大学(北京)人工智能硕士(在读)

主要研究方向为选矿设备、选矿流程的智能化。本科期间曾获全国大学生数学竞赛二等奖、北京市大学生数学竞赛一等奖、矿大(北京)第九届力学竞赛二等奖、校奖学金等。研究生阶段,目前正参与节能减排大赛(基于AI 算法的磨矿功率优化)、挑战杯(ChatGPT+预测性维护)等多项赛事。

骆陈真:luoyuheng961000(WX号)

赖祯松:Papadevilgang(WX号)

X

欢迎来到浩沃特!